W dniu 9 czerwca 2025 do redakcji portalu Nauka o klimacie wpłynął list prof. Macieja Dąbskiego, w którym autor wyraża oburzenie w związku z opublikowanym na łamach portalu tekstem Czy ze Stevenen Kooninem powinno się dyskutować? Tęsknota mediów za negacjonistami stanowiącym odpowiedź na felieton Witolda Gadomskiego z „Gazety Wyborczej” (treść listu dostępna pod tym linkiem). Dla przypomnienia, redaktor Gadomski stawiał w nim tezę, że brak dyskusji nad książką Stevena Koonina jest wynikiem „zmowy milczenia” środowiska akademickiego, zaś sama publikacja i dyskusja nad nią mogłaby pomóc w rozwijaniu nauki.

Profesor Dąbski zarzuca nam, że opublikowany przez nas tekst był „nieuczciwy, operujący półprawdami i arogancki”. Naszym celem nie było formułowanie zarzutów ad personam ani w stosunku do red. Gadomskiego, ani S. Koonina. Nasza krytyka dotyczyła konkretnych tez, które w naszej ocenie nie znajdują potwierdzenia w literaturze naukowej, a ich publiczne eksponowanie bez odpowiedniego kontekstu może prowadzić do dezinformacji. Jeśli którekolwiek z naszych sformułowań wydaje się niewystarczająco uzasadnione, jesteśmy gotowi je doprecyzować. Jednak, przede wszystkim, w duchu wzajemnego szacunku, chcielibyśmy odnieść się do krytycznych uwag, które znalazły się w nadesłanym liście.

Pozytywne recenzje Koonina

Prof. Maciej Dąbski zaczyna od postawienia zarzutu, że w naszym tekście nie wspomnieliśmy o pozytywnych recenzjach książki Koonina. Nie uważamy jednak, że było to obowiązkiem recenzenta: o ekspozycję entuzjastycznych „słów uznania” zadbał już, w materiałach reklamowych i wewnątrz samej książki, jej wydawca. Nasza recenzja też była zresztą odpowiedzią na felieton chwalącego książkę dziennikarza Gazety Wyborczej. Jak w niej napisaliśmy, zdajemy sobie sprawę, że osoba autora książki i jej pseudo-naukowa formuła może imponować niespecjalistom i czytelnikom słabiej orientującym się w poruszanych w niej zagadnieniach, albo posiadającym już wcześniej wyrobioną, sceptyczną opinię na temat (nie)istnienia kryzysu klimatycznego (przywoływany przez prof. Dąbskiego fizyk Robert Laughlin należy do obu kategorii).

Recenzje Vaclava Smila i Roberta Laughlina, na które powołuje się profesor Dąbski, to przede wszystkim poparcie dla krytyki polityki klimatycznej i kosztów z nią związanych, jednak żadna z nich nie analizuje dogłębnie poprawności danych, na które powołuje się Koonin. Recenzje te, nawet jeśli wyszły spod pióra znanych w środowisku naukowym autorów, nie stanowią naukowej walidacji książki Koonina, raczej wyrażają zgodność z prezentowaną przez niego linią poglądów.

Jeśli natomiast chodzi o Gary’ego Yohe, autora krytycznej wobec książki Koonina recenzji (opublikowanej w Scientific American), został przez nas wyraźnie podpisany jako profesor ekonomii i studiów środowiskowych. Yohe od lat specjalizuje się w ocenie ryzyka i podatności społeczno-ekonomicznej na zmianę klimatu. To, że Yohe nie jest klimatologiem, ma akurat w przypadku tej recenzji wartość dodaną, bo choć Koonin jest fizykiem, to wiele jego tez dotyczy ryzyka społecznego, ekonomicznego oraz podatności systemów – dokładnie tych obszarów, którymi Yohe zajmuje się od dekad. Krytyka przedstawiona przez Yohe dotyczyła nie tylko danych, ale także ich społeczno-ekonomicznych implikacji, czyli kwestii znajdujących się w zakresie jego kompetencji.

Fale upałów w USA

Maciej Dąbski zarzuca cytowanemu przez nas Gary’emu Yohe, że „dane pokazują wyraźnie” iż „mija się z prawdą” pisząc o falach upałów, bo „nie patrzy na pełny dostępny ciąg pomiarowy lecz tylko na ostatnie dekady”.

W swojej recenzji Yohe odnosił się do dwóch konkretnych twierdzeń z książki Koonina. To Koonin pisał o roku 1900 i ostatnich pięćdziesięciu latach, jeśli więc wybór takich punktów odniesienia w analizie danych oznacza „mijanie się z prawdą”, prof. Dąbski powinien kierować swoją krytykę do autora książki.

A co pokazują dane, i czy pokazują to wyraźnie? Jak słusznie zauważa Yohe, w kwestii zmian częstości występowania fal upałów dużo zależy od tego, jak te upały zdefiniujemy. Cytowany za Kooninem indeks fal upałów jest jedną (ale nie jedyną) miarą dotkliwości fal upałów, i jest kombinacją powierzchni oraz częstości występowania fal upałów na obszarze kontynentalnych USA.

Zakładając, że Koonin pisząc o „1900” roku miał na myśli nie pojedynczy rok, a dekadę 1900-1909, to wartość indeksu fal upałów dla tego okresu jest niemal dwukrotnie mniejsza niż dla dekady 2010-2019 (EPA, Climate change indicators, 2025), co oznacza że obecnie mamy do czynienia z dwukrotnie większą częstością i/lub powierzchnią występowania fal upałów niż w pierwszej dekadzie XX wieku.

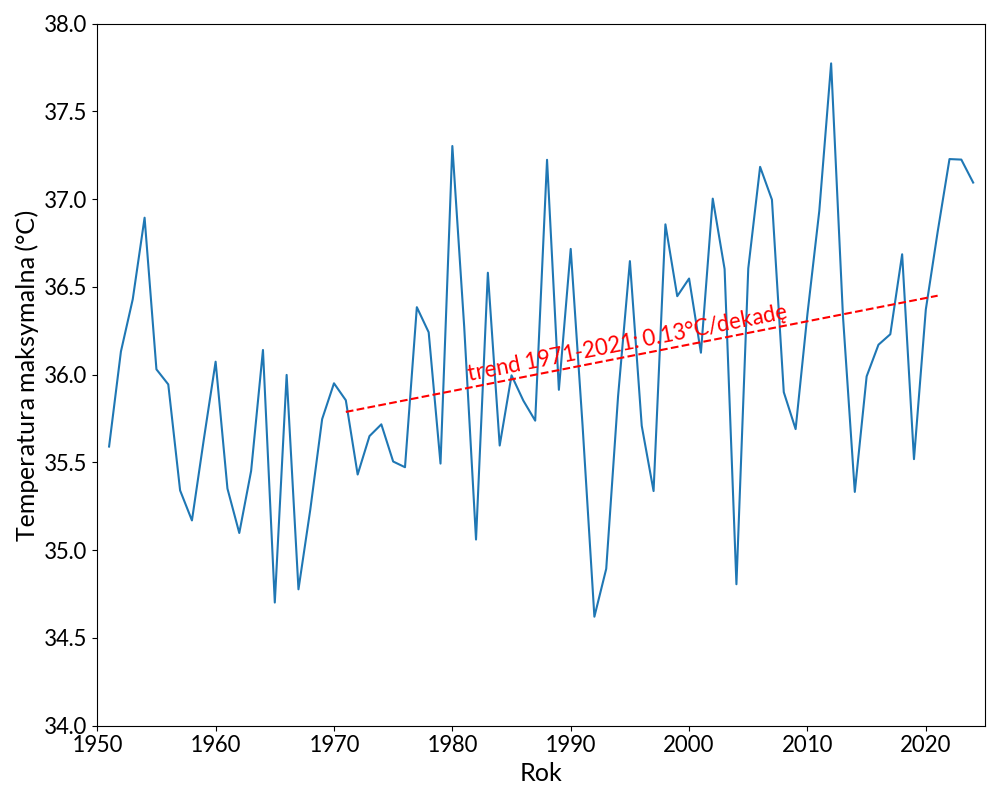

Drugim przywoływanym przez Koonina indeksem jest maksymalna temperatura zmierzona w danym roku, uśredniona dla całej powierzchni kontynentalnych Stanów Zjednoczonych. Ponownie jednak rację ma Yohe, a nie Koonin: w okresie o którym mowa w książce, czyli ostatnich pięćdziesięciu latach, tak obliczona temperatura rośnie w tempie około 0,13 stopnia na dekadę (wykres poniżej).

Profesor Dąbski uważa też że „Yohe operuje półprawdą”, nie pisząc o „zmianach umieralności z powodu dyskomfortu termicznego w skali świata”. To jednak pewne nieporozumienie: Yohe pisał o wzrastającej umieralności w kontekście fal upałów i tego że wpływ na nią mają cieplejsze, letnie noce, również na obszarze USA. Zjawisko cieplejszych zim (i zanikających ekstremów chłodu) to temat osobny, i z dwoma konkretnymi, krytykowanymi przez Yohe twierdzeniami Koonina o letnich falach upałów, nie ma bezpośredniego związku.

Grenlandia

Prof. Dąbski przywołuje rekonstrukcję bilansu masy lądolodu grenlandzkiego Mankoffa i in. (2021) celem udowodnienia, że Koonin miał rację, bo lądolód tracił masę w latach 1920. podobnie szybko jak w pierwszej dekadzie XXI wieku. Po pierwsze jednak, Koonin pisał nie o latach 1920., tylko o 1940., i porównywał to ze stanem dzisiejszym, a nie pierwszą dekadą XXI wieku. Po drugie, dane które cytuje profesor Dąbski wskazują, że w ostatniej pełnej dekadzie (lata 2010.) lądolód Grenlandii tracił średnio dwukrotnie więcej lodu (250 Gt/rok) niż w latach 1920. (130 Gt/rok) i trzykrotnie więcej niż w latach 1940. (75 Gt/rok).

Niestety, nie jest dużym pocieszeniem, że „od kilku lat bilans masy obu lądolodów poprawia się”. Roczne zmiany bilansu masy charakteryzują się pewną zmiennością, nie jest więc trudno znaleźć kilka lat, kiedy ubytek jest mniejszy niż w latach poprzedzających. Nie spodziewamy się jednak, aby ten ubytek zamienił się w przyrost, i by wraz z postępującym ociepleniem klimatu oba lądolody zaczęły rosnąć. W końcu, jak sam Maciej Dąbski zauważa w innym miejscu swojego listu, w przeszłości geologicznej Ziemi bywało cieplej niż obecnie, i towarzyszył temu wyższy poziom morza, czego przyczyną była częściowa albo całkowita deglacjacja lądolodów Grenlandii i Antarktydy. Nie ma powodów, aby sądzić, że tym razem ocieplenie spowoduje inne zachowanie lądolodów i że wraz ze wzrostem temperatury zaczną one rosnąć.

Koszty zmiany klimatu

Nie ma sprzeczności pomiędzy cytowaną w naszej recenzji tezą Yohe o tym, że koszty ekonomiczne zmiany klimatu do końca stulecia nie będą, wbrew temu co twierdzi Koonin, „minimalne”, a wzmiankowanymi przez profesora Dąbskiego wnioskami z pracy Formetta i Feyena (2019). Pierwsze dotyczy przyszłości, a drugie przeszłości (artykuł analizuje okres 1980-2016). Ponadto, nawet jeśli działania adaptacyjne redukują zagrożenia związane z takimi zjawiskami jak ulewne deszcze, fale upałów, wzrost poziomu morza czy tornada, działania te nie są bezkosztowe, i zazwyczaj związane z nimi koszty skalują się wraz z wielkością zmiany klimatu, przed którą mają chronić.

Konsensus, czułość klimatu i zjawiska ekstremalne

Według prof. Dąbskiego „nie ma konsensusu naukowego w kwestii mocy z jaką emisje gazów cieplarnianych oddziałują na klimat”, gdyż „IPCC nie ustalił”, jaka jest wartość czułości klimatu. To nieporozumienie: w naukach przyrodniczych parametry takie jak czułość klimatu zawsze poznawane są w oparciu o pomiary i ich analizę statystyczną, z niezerową niepewnością. Samo istnienie niepewności nie oznacza braku konsensusu, ani że czegoś nie ustalono. O takiej sytuacji można byłoby mówić, gdyby wartości badanego parametru ustalone różnymi metodami albo pomiarami były ze sobą sprzeczne, a ich zakresy niepewności — rozłączne.

W przypadku czułości klimatu od dawna wiemy, m. in. dzięki pionierskim, nagrodzonym nagrodą Nobla 2021 badaniom Syukuro Manabe z lat sześćdziesiątych i siedemdziesiątych, że wynosi ona “około” 3 stopnie Celsjusza na podwojenie zawartości dwutlenku węgla w atmosferze. To “około” oznacza (niesymetryczny) zakres niepewności od 2 do 5 stopni, i obejmuje szeroki konsensus wyników uzyskanych poprzez analizę teorii procesów klimatycznych, różnych rodzajów modeli, pomiarów historycznych i rekonstrukcji paleoklimatycznych (Sherwood i in., 2020).

Oczywiście, nie wszystkie aspekty zmiany klimatu są poznane równie dobrze, zdarza się też, że zjawiska których występowanie przewidujemy (w oparciu o argumenty teoretyczne, albo modelowanie numeryczne) nie zostały jeszcze bezdyskusyjnie wykryte w danych obserwacyjnych. Czasami sygnał związany ze zmianą klimatu jest wciąż względnie niewielki w porównaniu do naturalnej zmienności klimatycznej, czasami obserwacje historyczne są niedoskonałe i nie pozwalają nam na wyciągnięcie jednoznacznych wniosków. Sytuacja taka dotyka obszar badań związanych ze zjawiskami ekstremalnymi, które z definicji są zdarzeniami rzadkimi i jako takie sprawiają problemy natury statystycznej.

Albedo

W obronie wyników badań projektu BBSO Earthshine nad zmianami albedo profesor Dąbski powołuje się na pracę Goesslinga i in. (2024), o której pisaliśmy kilka miesięcy temu w artykule Globalne ocieplenie zabiera nam chmury. Zastrzeżenia wobec pierwszych wniosków z BBSO Earthshine nie dotyczą jednak tego, że zmiany zachmurzenia nie wpływają na albedo Ziemi – bo wpływają – ani że nie mają wpływu na bilans radiacyjny i średnią temperaturę planety – bo oczywiście mają. Chodzi o to, że pierwsze analizy danych z projektu Earthshine wskazywały jednak na zmienność albedo kilkakrotnie większą niż rzeczywista, i którą zmierzono innymi metodami. Widać to nawet w pracy, o której pisze Maciej Dąbski: pomiary strumienia pochłoniętego promieniowania słonecznego zmierzone przez instrumenty satelitarne CERES (rys. 2 u Goesslinga i in.) wskazują na bardzo niewielkie zmiany (o około 1 W/m²) w okresie 2000-2003; Koonin i jego współautorzy w pracy z 2004 roku (Pallé i in., 2004) widzieli tutaj spadek aż o 6 W/m². Podkreślmy jeszcze raz, że w poprawionej analizie danych projektu Earthshine, Koonin i jego współautorzy tak dużych zmian albedo już nie znaleźli (Goode i in., 2021).

Promieniowanie kosmiczne

Profesor Dąbski broni też hipotezy o związku zachmurzenia ze strumieniem promieniowania kosmicznego, powołując się na artykuł Kumara i in. (2023). Jeśli jednak przyjrzymy się dokładniej wnioskom autorów, odkryjemy że „korelacje o różnym znaku, dość silne i zależne od regionu i wysokości chmur” oznaczają współczynniki korelacji równe -0,54 dla chmur piętra niskiego, 0,42 dla chmur piętra średniego i 0,26 dla chmur piętra wysokiego. Nawet więc akceptując te wyniki jako poprawne, oznaczałoby to, że strumień promieniowania kosmicznego jest odwrotnie skorelowany z wielkością pokrywy niskich chmur (których wkład w zmiany albedo jest największy), a zatem wzrost aktywności słonecznej (i związany z nim spadek strumienia promieniowania kosmicznego) powinien powodować wzrost zachmurzenia i globalne ochłodzenie – odwrotnie, niż twierdzili proponenci hipotezy o wpływie promieniowania kosmicznego na klimat.

Ponieważ jednak, zgodnie z analizą Kumara i in. strumień promieniowania kosmicznego jest też dodatnio skorelowany z pokrywą chmur piętra średniego, oba efekty w praktyce wzajemnie by się niwelowały… gdyby te korelacje faktycznie odzwierciedlały głębszy związek przyczynowo-skutkowy.

Czy tak jednak jest w istocie? W artykule Kumara i in. przytaczane wartości współczynnika korelacji są w większości efektem istnienia długoterminowych trendów w analizowanych szeregach: wzrostowego trendu promieniowania kosmicznego, spadkowego trendu pokrywy chmur piętra niskiego, i ponownie wzrostowego trendu pokrywy chmur piętra średniego. W krótszych skalach czasowych, w których przecież też powinien być wyraźny wpływ jonizacji na nukleację chmur, korelacja znika (rys. 2b w cytowanej pracy). Widać to chociażby w ostatnim, 25. cyklu słonecznym: wraz ze wzrostem aktywności Słońca pomiędzy minimum, osiągniętym w roku 2020, a obecnym maksimum (i związanym z nim spadkiem strumienia promieniowania kosmicznego, którego to związku, wbrew sugestii prof. Dąbskiego, nikt nie kwestionuje), zgodnie z wynikami Kumara i in. powinniśmy też obserwować wzrost pokrywy chmur piętra niskiego. Jak wiemy z przytaczanego również przez Macieja Dąbskiego badania Goesslinga, tak się jednak nie stało (patrz też Globalne ocieplenie zabiera nam chmury).

Na poparcie hipotezy o wpływie promieniowania kosmicznego na klimat profesor Dąbski przywołuje też wyniki badań o związku między wykonanymi w latach 1960. atmosferycznymi testami jądrowymi a opadami deszczu (Harrison i in. 2020). Zjawisko to, nawet jeśli jest rzeczywiste, jest skutkiem ekstremalnych i niewystępujących obecnie w ziemskiej atmosferze warunków. Możemy mieć jednak wątpliwości, czy faktycznie jest rzeczywiste: rys. 3b z pracy pokazuje, że jest to efekt bardzo subtelny, a autorzy koncentrują się na szukaniu korelacji z opadami deszczu. Można byłoby też zastanawiać się, dlaczego analizowane jest tylko zachmurzenie z jednego obserwatorium w Lerwick, skoro efekt powinien być globalny. Sam fakt że korelacja ze zmianami zachmurzenia dotyczy tylko dni, w które w odległym o 1000 kilometrów Kew zachmurzenia nie było, sugeruje, że może być ona przypadkowa i niereplikowalna obserwacjami z innych stacji.

Postulowany w kolejnej cytowanej przez prof. Dąbskiego pracy (Shaviv i in. 2023) związek pomiędzy jonizacją atmosfery a temperaturą w fanerozoiku został zdiagnozowany w oparciu o dopasowanie dwóch krzywych: rekonstruowanej temperatury i strumienia galaktycznego promieniowania kosmicznego w ciągu ostatniego pół miliarda lat. Ponieważ są one obciążone bardzo dużymi niepewnościami i zależą od wielu trudnych do weryfikacji założeń (np. dotyczących struktury Drogi Mlecznej, czy stabilności geochemii oceanów – patrz Grossman i Joachimski, 2022, rys. 5) trudno jest uznać wnioski autorów za „bardzo prawdopodobne”.

Na koniec zaznaczmy, że posiadamy współczesne pomiary wielu parametrów związanych z ziemską atmosferą i aktywnością słoneczną, w ilości o kilka rzędów wielkości większej niż dane analizowane przez Harrisona i in. (analiza korelacji zachmurzenia jest tu oparta o dwie próbki pomiarów z 71 dni, a serie pomiarowe globalnych wahań zachmurzenia i strumienia promieniowania kosmicznego liczą 30-40 lat), i mierzone z dokładnością o wiele rzędów wielkości większą niż rekonstruowane przez Shaviva i in.[i] Pomiary te wskazują, że udział wahań promieniowania kosmicznego w zmianach klimatu obserwowanych w ostatnich dekadach był w najlepszym wypadku minimalny (np. Pierce 2017 i cytowane w niej prace).

Podkreślmy jednak jeszcze raz: żadna z przywoływanych przez prof. Dąbskiego prac, niezależnie od jej wniosków, nie sprawia że opublikowane przez Koonina i jego współautorów ponad dwadzieścia lat temu wyniki projektu BBSO Earthshine przestaną być niepoprawne.

Koonin a modelowanie klimatu

Prof. Maciej Dąbski w swoim liście pisze, że Koonin „ma duże kompetencje do wypowiadania się w kwestii modeli komputerowych”. Nie kwestionujemy kompetencji Koonina w zakresie, którym zajmował się naukowo, jak modelowanie zderzeń ciężkich jonów. Tym niemniej, jak pokazaliśmy w naszej recenzji, błędy i nadinterpretacje zawarte w jego książce wskazują, że jego wiedza na temat konkretnie modelowania klimatu jest powierzchowna. Poruszonych w naszej krytyce kwestii dotyczących modelowania prof. Dąbski nie kontestuje, zamiast tego podnosi nowe.

Zmiany temperatury troposfery

Profesor Dąbski pyta się, jak wyjaśnić „zdecydowaną niezgodność modelowanych temperatur górnej tropikalnej atmosfery z bezpośrednimi pomiarami jaką wykazali Christy, McNider (2017) i McKitrick, Christy (2018)”. Problem ten istnieje w klimatologii już 30 lat, na szczęście możemy podać przynajmniej częściowe jego wyjaśnienie.

Modele klimatu nie są idealną reprezentacją rzeczywistości, można więc spodziewać się różnic wynikających z niedoskonałej reprezentacji procesów fizycznych, zwłaszcza tych zachodzących w skalach niższych niż rozdzielczość modelu. Błędy mogą dotyczyć również konfiguracji przeprowadzanych symulacji albo zasilających je warunków brzegowych (wymuszeń), Jak np. nieciągłość danych o emisji sadzy pochodzącej ze spalanej biomasy roślinnej patrz Po-Chedley, 2022 czy Casas i in., 2022).

Wiemy jednak, że różnice pomiędzy modelowanymi a obserwowanymi (satelitarnie, radiometrami MSU/AMSU i radiosondami) trendami temperatury górnej tropikalnej troposfery są znacznie zredukowane w symulacjach typu AMIP, czyli takich, w których model atmosfery jest sprzężony z obserwowanymi zmianami temperatury oceanów. Wskazuje to, że wzmocnione ocieplenie górnej troposfery jest realnym, odzwierciedlanym przez modele fenomenem. Oznacza to też, że w przypadku symulacji modeli sprzężonych (o których mowa w cytowanych przez prof. Dąbskiego artykułach) wartość modelowanego trendu będzie zdominowana przez wielodekadową zmienność systemu klimatycznego (jak oscylacje pacyficzne IPO i PDO). Rzeczywisty świat dostarcza nam tylko jednej realizacji tej zmienności, sprzężone modele klimatyczne próbkują zaś cały ich rozkład, i za część rozbieżności odpowiada właśnie nieuwzględnienie przy porównaniu trendów, całego zakresu rozkładu tej zmienności (Chung i in., 2022, Po-Chedley i in., 2021).

Z drugiej strony, pomiary temperatury atmosfery też nie są doskonałe i są obciążone niemałymi błędami systematycznymi. W przypadku pomiarów satelitarnych wynikają one z degradacji instrumentów i samych orbit, a także problemów ze wzajemną kalibracją danych z różnych satelitów. Dodatkowo, ponieważ mierzą promieniowanie emitowane przez różne warstwy atmosfery, konieczne jest usunięcie wpływu emisji ochładzającej się stratosfery (więcej na te tematy: Co satelity mówią o ociepleniu atmosfery). Pomiary radiosondowe z kolei są ograniczone w przeważającej większości do obszarów lądowych półkuli północnej i niższych wysokości troposfery. Pomiary radiookultacji atmosfery są najmłodszą, choć bardzo obiecującą techniką obserwacyjną, i mają własne rodzaje błędów systematycznych. Trendy temperatury uzyskane w oparciu o pomiary wykonane różnymi metodami znacznie się różnią (Steiner i in, 2020, zwłaszcza rys. 10b, 13b.), a pomiary wykonane metodami radiookultacji oraz teledetekcji emisji podczerwieni są spójne z symulacjami modeli klimatu (Vergados i in, 2020 oraz Ladstädter i in., 2023 i Zhou i in., 2025).

Niezgodność między modelowanymi a mierzonymi temperaturami tropikalnej troposfery nie jest więc zdecydowana, i nie występuje we wszystkich analizach pomiarów.

Modelowanie klimatu holocenu i fanerozoiku

W temacie rozbieżności symulacji i rekonstrukcji temperatur w holocenie odsyłamy do naszego artykułu sprzed kilku lat (Zagwozdka temperatur holocenu). Kwestia ta wciąż pozostaje dzisiaj nierozstrzygnięta (Chen i in., 2023), choć dotychczas przeprowadzane badania wskazują na niedoskonałości rekonstrukcji warunków panujących na Ziemi tysiące lat temu (np. Wan i in., 2024) , oraz konfiguracji modeli klimatu (np. Chen i in., 2024 czy Jiang i in., 2024).

Jeśli chodzi o rekonstrukcję klimatu fanerozoiku, powtórzymy to co wcześniej pisaliśmy o pracy Shaviva i in.: zarówno temperatura jak i koncentracja dwutlenku węgla w atmosferze rekonstruowana jest z dużymi niepewnościami, niewidocznymi na wykresie załączonym przez prof. Dąbskiego, choć obecnymi w cytowanym przez niego artykule źródłowych. Nie spodziewamy się więc idealnej korelacji tych dwóch krzywych, tym bardziej, że nie oczekujemy też, że wahania dwutlenku węgla były jedynym czynnikiem decydującym o klimacie w przeszłości geologicznej Ziemi. W ciągu pół miliarda lat zmieniało się położenie kontynentów, ukształtowanie basenów oceanicznych, pojawiały i znikały pasma górskie i rzeki, ewoluowały całkowicie nowe rodzaje roślin i zwierząt. Kiedy więc napotykamy w paleoklimatologii takie problemy jak „w okresie neoglacjalnym temperatura spadała a stężenie CO₂ rosło”, albo że „korelacja między CO₂ a temperaturą była zerowa lub ujemna przez ok 250 mln lat”, nie jest to powodem by nagle zacząć wątpić w ustalenia dotyczące współczesnej zmiany klimatu czy wyrzucić do kosza fizykę gazów cieplarnianych. Nasza wiedza na temat zmian klimatu w odległej przeszłości jest i zawsze będzie oparta o dane pośrednie, zawsze będzie niepełna, i siłą rzeczy będzie ograniczać nasze możliwości bezbłędnego modelowania Ziemi sprzed tysięcy czy milionów lat.

Globalne ocieplenie w latach 1940.

Związana z tym jest kolejna kwestia podniesiona przez prof. Dąbskiego. Trudno jest bez cienia wątpliwości orzekać o przyczynach zjawisk klimatycznych z przeszłości – nawet relatywnie nieodległej, jak lata drugiej wojny światowej – jeśli nie dysponujemy odpowiednimi danymi obserwacyjnymi, a te którymi dysponujemy, wciąż są obciążone różnymi błędami systematycznymi. Nie możemy jednak cofnąć się w czasie i wykonać obserwacji satelitarnych planety w roku 1940; nie możemy rozmieścić boi pomiarowych na oceanach, aby zastąpić niedoskonałe pomiary ówczesnych statków i okrętów; nie możemy zmienić praktyk obserwacyjnych pracujących wtedy meteorologów. Musimy zatem pracować z niedoskonałymi danymi będącymi wynikiem niedokładnie przeprowadzanych pomiarów.

Argumenty przemawiające za tym, że część widzianego w szeregach temperatury oceanów ocieplenia w latach lat 1930. i 1940. jest artefaktem danych a nie realnym zjawiskiem fizycznym, zawsze będą więc natury pośredniej, i to mieliśmy na myśli używając słowa „poszlaki” (a nie np. silniejszego „dowody”). Tym niemniej, pewne rzeczy wiemy na pewno: między innymi to, że przebieg drugiej wojny światowej skutkował dużymi zmianami w lokalizacji i sposobie wykonywania pomiarów temperatury oceanów. Wiemy, że bitwa o Atlantyk spowodowała spadek liczby obserwacji wykonywanych przez brytyjską marynarkę handlową; wiemy że atak na Pearl Harbour miał podobne skutki na Pacyfiku; wiemy że w czasie wojny częściej mierzono temperaturę wody morskiej używanej do chłodzenia silników okrętowych, i że woda ta była zazwyczaj cieplejsza od tej pobieranej tradycyjnymi metodami (ciągniętym za rufą wiadrem). Wiemy, że czynniki te miały duży wpływ na analizy zmian temperatury oceanów, i choć klimatolodzy starają się ten wpływ uwzględniać i usuwać w procesie zwanym homogenizacją, mamy poszlaki że szeregi temperatury globalnej, takie jak te cytowane przez Koonina, wciąż zawierają błędy systematyczne zawyżające amplitudę zmian w okolicach II wojny światowej.

Oczywiście, problemy te znane są klimatologom od dawna (patrz np. Brooks, 1926 i Barnett, 1984) i był przedmiotem wielu badań, więc jeśli prof. Dąbski jest zainteresowany tematem, odsyłamy do literatury naukowej na ten właśnie temat (Sippel i in., 2024, Chan i Huybers, 2021, Thompson i in., 2009, Thompson i in., 2008, Chan i in., 2019, Cowtan i in., 2017, Kennedy i in., 2011, Carella i in., 2017).

Maciej Dąbski twierdzi dalej, że posiada poszlaki, że „NASA fałszuje dane, żeby sztucznie zawyżyć współczesne tempo ocieplania”. Jeśli takie poszlaki faktycznie posiada, zachęcamy aby je publicznie ujawnił, będzie to z korzyścią dla nas, innych osób korzystających z danych NASA, i całej nauki. Podejrzewamy jednak, że insynuacje te – jak wiele podobnych, które powtarzane były przez wiele lat w środowisku osób kwestionujących globalne ocieplenie – mogą być oparte na znalezionych w internecie teoriach spiskowych, wynikające z niezrozumienia danych, metod pomiaru i sposobów ich przetwarzania.

Czy współczesne ocieplenie może mieć naturalne przyczyny?

Na zakończenie swojego listu prof. Dąbski pyta, czy czynniki naturalne mogły się przyczynić do współczesnego ocieplenia. Uczciwie odpowiadamy, że nie, a załączone przez niego przez niego wykresy tego nie pokazują. Przykładowo, źródło wykresu irradiancji słonecznej (Lindsey 2025) odnotowuje, pod nagłówkiem „Aktywność słoneczna nie może być wyjaśnieniem globalnego ocieplenia”, że zmiana aktywności słonecznej może odpowiadać za zaledwie 1% globalnego ocieplenia obserwowanego od połowy XIX wieku.

Aby wykazać znaczący czy dominujący wpływ naturalnych czynników na globalne ocieplenie w ostatnich dekadach, potrzebna jest spójna teoria, zawierająca opis mechanizmu fizycznego wyjaśniającego obserwowane zmiany, i jednocześnie tłumacząca dlaczego teoria dotychczas akceptowana jako poprawna (wzmocnienie efektu cieplarnianego spowodowanego emisją gazów cieplarnianych), poprawną nie jest. Garść wykresów niepowiązanych spójną hipotezą to niestety trochę za mało.

Na koniec: kwestie retoryczne i pozamerytoryczne

W liście pojawiła się prośba o nieetykietowanie głosów polemicznych jako „denialistycznych” – staraliśmy się ją uszanować, jednak zarzut, że porównujemy osoby mające odmienny pogląd do „płaskoziemców”, wymaga doprecyzowania. Intencją umieszczenia żartobliwej ilustracji było zobrazowanie dysproporcji między wiedzą opartą na konsensusie naukowym a stanowiskami mniejszościowymi, a nie obrażanie przedstawicieli tych stanowisk. Pojęcia takie jak „denializm” czy „negacjonizm klimatyczny” są to zjawiska wielokrotnie opisane w literaturze naukowej (Oreskes i Conway, 2010; McCright i Dunlap, 2011, Dunlap i Brulle, 2015) i służą do określenia konkretnych postaw np. odrzucaniu konsensusu naukowego. Nie mają one na celu osobistego ataku, ale wskazanie określonych strategii retorycznych, które zostały zidentyfikowane jako szkodliwe dla debaty publicznej.

Użycie określenia „skrajnie nieodpowiedzialne” wobec felietonu red. Gadomskiego wynikało z troski o rzetelność przekazu naukowego oraz podkreślenia odpowiedzialności mediów — i nie tylko mediów — za kształtowanie tego przekazu w przestrzeni publicznej. Bo choć otwarta debata jest podstawą nauki, książka Koonina jest próbą pójścia na skróty i ominięcia związanych z nią rygorów: konieczności przeprowadzania badań naukowych, publikacji ich wyników, procesu recenzenckiego. Rozumiemy, że przygotowanie treści popularnonaukowych wiąże się często z różnymi kompromisami i uproszczeniami, ale jednostronnej, selektywnej, a czasami — jak pokazaliśmy powyżej i w naszej pierwotnej recenzji — zwyczajnie błędnej argumentacji Koonina nie da się w ten sposób wybronić, tym bardziej że zaczyna być ona cytowana w literaturze naukowej jako przykład uzasadnionych wątpliwości środowiska naukowego co do ustaleń klimatologii. Dziękujemy więc prof. Dąbskiemu za jego list i mamy nadzieję, że rozwijaliśmy jego wątpliwości, oraz że zarówno on, jak nasi czytelnicy lepiej zrozumieją źródła naszej krytyki książki Koonina.

i Dla przykładu, Shaviv i in. używają rekonstrukcji koncentracji dwutlenku węgla opartej o wyliczenia modelu GEOCARB-SULF z 2006 roku. W rekonstrukcji tej niepewność poziomu CO₂ dla większości fanerozoiku wynosi od kilkuset od kilku tysięcy ppm (https://doi.org/10.2475/09.2014.01). Obecny poziom dwutlenku węgla mierzymy z dokładnością do kilku dziesiątych części ppm. Wróć do tekstu.

The post Dyskusji o książce Koonina ciąg dalszy – odpowiedź na list prof. Dąbskiego appeared first on Nauka o klimacie | naukaoklimacie.pl.

Dodaj komentarz